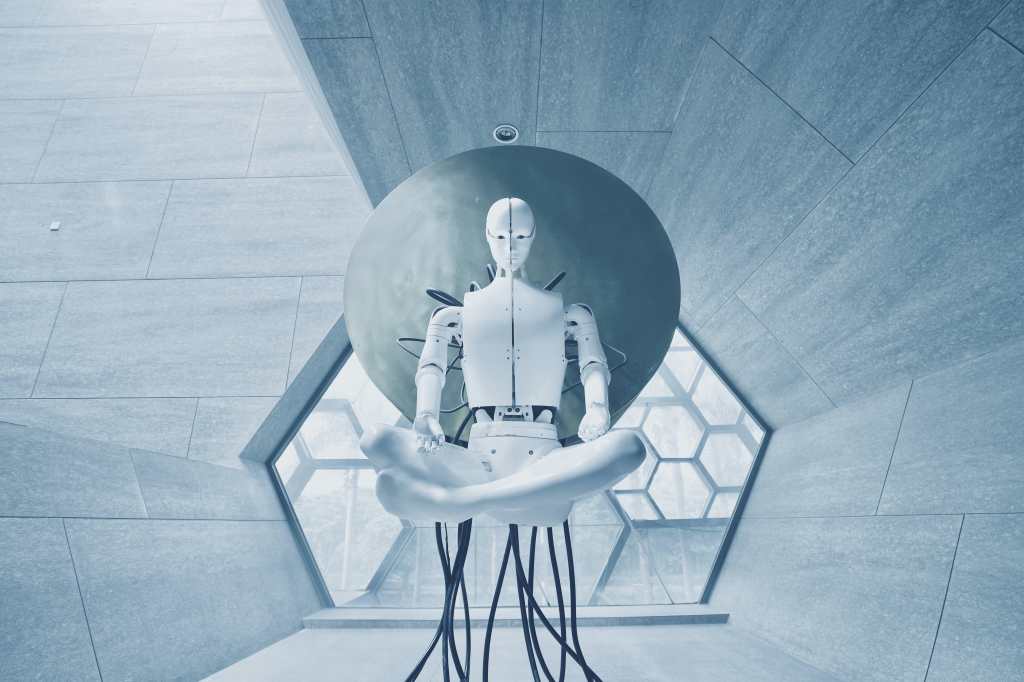

VC-1 es un modelo de percepción que, por primera vez, es compatible con una amplia gama de habilidades sensomotoras, entornos y personificaciones.

“VC-1 se entrena con videos de personas realizando tareas cotidianas del innovador conjunto de datos Ego4D creado por Meta IA y socios académicos. Y VC-1 iguala o supera los resultados más conocidos en 17 tareas sensomotoras diferentes en entornos virtuales”, explica un comunicado.

Por su parte, ASC que logra en entornos físico un rendimiento “casi perfecto”, con un 98% de éxito, según el comunicado, en la desafiante tarea de copiado móvil robótico, como por ejemplo dirigirse hasta un objeto, recogerlo, desplazarse hasta otra ubicación y colocar el objeto.

Una de las características de la IA es que necesita datos de los que aprender y en ambos casos, se desarrollaron “nuevas formas para que los robots aprendan, utilizando videos de interacciones humanas con el mundo real e interacciones simuladas dentro de mundos simulados”.

Además, el comunicado destaca que Meta está interesado en desarrollar de manera artificial una corteza visual, réplica de la región del cerebro que (junto con la corteza motora) permite que un organismo convierta la visión en movimiento.

Today, we're sharing two major advancements in our work toward general-purpose embodied AI agents: VC-1 & ASC. We're excited for how this work will help build toward a future where AI agents can assist humans in both the virtual & physical world.

Details ⬇️

— Meta AI (@MetaAI) March 31, 2023

“El módulo es un sistema de IA que permite a un agente artificial convertir la entrada de la cámara en acciones”, apunta el comunicado.