Según el organismo, TikTok no cuenta “con sistemas adecuados para supervisar el contenido publicado por terceros y no se aplican las normas de la remoción de contenido peligroso que incite al suicidio, autolesiones e información incorrecta”, explicó en una nota.

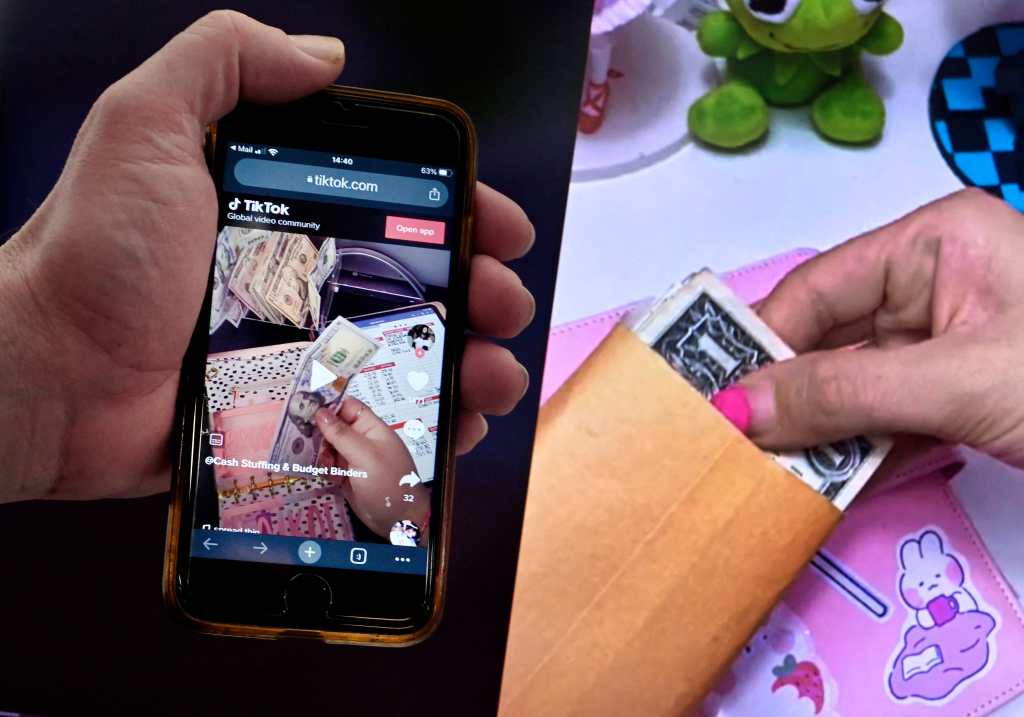

La investigación se centra en la última tendencia autolesiva que ha aparecido en la plataforma china y que llega desde Francia y que consiste en pellizcarse los pómulos con tanta fuerza y durante tanto tiempo que tiene que salir un moratón, pero que puede incluso dejar señales permanentes.

La AGCM añade que “se investiga que TikTok no haya establecido sistemas de seguimiento adecuados para supervisar los contenidos publicados por terceros, según los parámetros requeridos, y sobre todo en presencia de usuarios del servicio especialmente vulnerables como los menores”.

Lea más: TikTok: cómo funcionará el límite de 60 minutos para usuarios menores a 18 años

También se está investigando “la explotación de técnicas de inteligencia artificial susceptibles de provocar un condicionamiento indebido de los usuarios”.

“La referencia es, en particular, al algoritmo subyacente al funcionamiento de la plataforma que, utilizando los datos del usuario, personaliza la visualización de publicidad y vuelve a proponer contenidos similares a los que ya se muestran y con los que se ha interactuado a través de la función Me gusta”, explica.

Lea también: Retos virales: ¿Cómo pueden los padres proteger a sus hijos de los juegos peligrosos?